Dzięki filmom z kamery umieszczanej na głowach dzieci naukowcy mają nadzieję wytrenować model językowy, korzystając z tych samych danych, z którymi styka się niemowlę

Piotr Mazurkiewicz

Projekt prowadzony przez Brendana Lake’a, psychologa z Uniwersytetu Nowojorskiego, opisuje dziennik „The New York Times”. Bierze w nim udział również niemal 2-letnia córka naukowca, Luna. Jak opisuje badacz, w projekcie chodzi o zrozumienie, jak dochodzi do momentu, gdy zaczynamy rozumieć, że to samo słowo może mieć różne znaczenia. Niektórzy naukowcy argumentują, że większość nauki języka można wyjaśnić uczeniem skojarzeniowym, ponieważ wiążemy dźwięki z wrażliwością, podobnie jak psy kojarzą dźwięk dzwonka z jedzeniem. Inni twierdzą, że w ludzki umysł wbudowane są cechy, które ukształtowały formy wszystkich języków i są kluczowe dla naszej nauki.

Niemowlę z kamerą na głowie

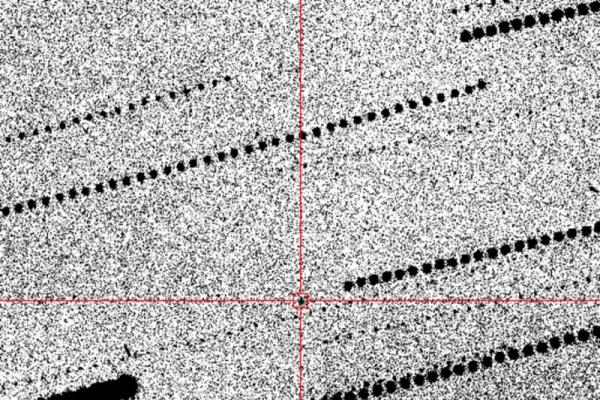

Przez ostatnie 11 miesięcy co tydzień przez godzinę dr Lake, którego badania koncentrują się na człowieku i sztucznej inteligencji, podłączał Lunie ma głowie kamerkę GoPro i podczas zabawy nagrywał wszystko z jej punktu widzenia. Jego celem jest wykorzystanie filmów do szkolenia modelu językowego przy użyciu tych samych bodźców zmysłowych, z którymi styka się małe dziecko. W ten sposób chce stworzyć lepsze narzędzia dla sztucznej inteligencji. Dzięki filmom z kamery Luny dr Lake ma nadzieję wytrenować model językowy, korzystając z tych samych danych, z którymi styka się małe dziecko.

Dziennik „NYT” zauważa, że nowoczesne modele językowe i multimodalne — takie jak GPT-4 OpenAI i Gemini firmy Google — są montowane w sieciach neuronowych o niewielkiej wbudowanej strukturze i zostały ulepszone głównie w wyniku zwiększonej mocy obliczeniowej i większych zbiorów danych szkoleniowych. Najnowszy model dużego języka Meta, Llama 3, jest uczony na ponad dziesięciu bilionach słów, tymczasem przeciętny pięciolatek ma kontakt z ponad 300 tys. słów.

Takie modele mogą analizować piksele na obrazach, ale nie są w stanie poczuć smaku sera ani jagód ani odczuwać głodu, co jest ważnym rodzajem doświadczeń edukacyjnych dla dzieci. Badacze mogą dołożyć wszelkich starań, aby zamienić pełny strumień zmysłów dziecka w kod, ale kluczowe aspekty zostaną pominięte. – To, co widzimy, to jedynie pozostałość po aktywnym uczeniu – mówi Michael Frank, psycholog ze Stanford, który od lat próbuje uchwycić przed kamerą ludzkie doświadczenia. Jego laboratorium współpracuje obecnie z ponad 25 dziećmi, w tym z Luną, aby rejestrować ich doświadczenia w domu i w otoczeniu społecznym.

Ludzie nie są także zwykłymi pojemnikami na dane, jak sieci neuronowe. Wszystko, co widzimy, każdy przedmiot, którego dotykamy, każde słowo, które słyszymy, łączy się z przekonaniami i pragnieniami, które mamy w danej chwili. – Istnieje głęboki związek między tym, czego próbujesz się dowiedzieć, a danymi, które napływają – mówi Linda Smith, psycholog z Indiana University. Te modele po prostu przewidują. Biorą wszystko, co się w nie wkłada, i próbują z tego stworzyć kolejny najlepszy krok.

Rozgryzanie i uczenie sztucznej inteligencji

Niedawno w laboratoriach branżowych Google i Microsoftu po wydaniu nowych modeli pojawiły się wątpliwe twierdzenia dotyczące świadomości, ogólnej inteligencji i wrażliwości. W marcu Claude 3, najnowszy model start-upu badawczego AI o nazwie Anthropic, wywołał dyskusję, gdy po przeanalizowaniu niepasującego zdania na temat dodatków do pizzy ukrytego na długiej liście niepowiązanych ze sobą tekstów wyraził podejrzenie, że jest testowany.

Ale ludzkie umysły łączą się z wirtualnymi w inny sposób. Tom Griffiths, kognitywista z Princeton, zasugerował, że opisując ograniczenia ludzkiej inteligencji i budując modele, które mają podobne ograniczenia, moglibyśmy osiągnąć lepsze zrozumienie siebie i lepszą interpretację, wydajniejszą sztuczną inteligencję.

W lutym dr Lake i jego współpracownicy stworzyli pierwszą w historii sztuczną inteligencję, przeszkoloną na doświadczeniach dziecka, korzystając z filmów nagranych w laboratorium doktora Franka ponad dziesięć lat temu.

Na ile możemy stworzyć sztuczną inteligencję przypominającą człowieka? Co czyni nas ludźmi? Zagłębianie się w pierwsze pytanie kawałek po kawałku, modelowanie interakcji społecznych, intencji i uprzedzeń, poprzez zbieranie obszernego materiału wideo z kamery zamontowanej na głowie rocznego dziecka, oznacza przybliżanie się do odpowiedzi na drugie pytanie.