Sztuczna inteligencja wskazuje cele w Gazie z dużą precyzją, ale jej działanie przynosi wiąże się też z wieloma ofiarami cywilnymi

Paweł Rożyński

Kiedy Izrael odpowiedział na krwawy atak Hamasu z 7 października ubiegłego roku, a zwłaszcza po niedawnym uderzeniu na konwój z pomocą humanitarną dla mieszkańców Gazy, w której zginął Polak Damian Soból, głośno zrobiło się o nowych systemach sztucznej inteligencji, które są wykorzystywane w walkach. Izrael nie jest wyjątkiem. Takie systemy wchodzą obecnie na uzbrojenie czołowych armii świata.

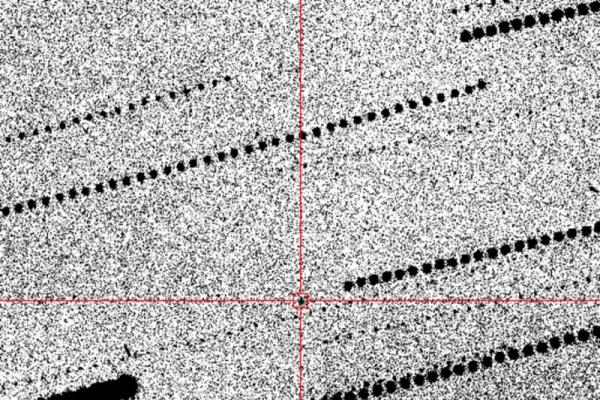

Mają wynajdywać cele z niespotykaną dotąd precyzją na podstawie licznych danych (pochodzą z wielu różnych źródeł, jak smartfony, zdjęcia satelitarne, nagrania z dronów) i wskazywać współrzędne operatorowi, który tylko pociąga za spust. Ale też możliwe są już ataki przeprowadzane w sposób autonomiczny, a decyzje teoretycznie może podejmować samodzielnie sztuczna inteligencja.

Ewangelista i Lawenda

Śledztwo dziennikarskie Yuvala Abrahama z izraelsko-palestyńskiego portalu +972 Magazine przyniosło właśnie dość szokujące rezultaty. Z anonimowych zeznań sześciu oficerów izraelskiego wywiadu, którzy byli zaangażowani w wykorzystanie systemów sztucznej inteligencji do identyfikacji celów podczas wojny z Hamasem wynika, że armia oznaczyła nawet 37 tysięcy mieszkańców Gazy jako terrorystów, korzystając z narzędzia „Lawender” (ang. lawenda). Oprogramowanie to miało odegrać znaczącą rolę w bombardowaniach przeprowadzonych na terenie Strefy Gazy w pierwszych tygodniach po ataku Hamasu na Izrael. – Zdarzały się sytuacje, w których Hamas był definiowany szerzej. Wtedy system sugerował nam wszelkiego rodzaju pracowników obrony cywilnej czy policjantów. Pomagają oni Hamasowi, ale nie stanowią zagrożenia – twierdzi jedno ze źródeł portali.

+972 Magazine podał, że margines błędu oprogramowania miał wynosić około 10 procent, a izraelska armia miała być świadoma niedoskonałości systemu. Na weryfikację tego, czy dana osoba powinna zostać uznana za cel i zabita poświęcano „jedynie 20 sekund”. Upewniano się tylko, że cel jest mężczyzną. Algorytmy miały też sugerować przede wszystkim zaskakujące ataki nocne. Według nieoficjalnych źródeł akceptowano „uboczne” straty cywilne rzędu 15 lub 20 osob cywilów w przypadku atakowania członków Hamasu niskiego szczebla, zaś wyższego – nawet 100 cywilów.

Po 7 października dowódcy armii izraelskiej domagali się od wywiadu dostarczania coraz większej ilości celów. – Ciągle byliśmy pod presją: „Przynieście nam więcej celów”. Naprawdę na nas krzyczeli – powiedział jeden z oficerów wywiadu. – Powiedziano nam, że teraz musimy zniszczyć Hamas, bez względu na koszty. Cokolwiek możesz, zbombardujesz.

Informacjom portalu zaprzeczyły Izraelskie Siły Obronne. Twierdzą, że sztuczna inteligencja nie była wykorzystywana do identyfikowania celów. „IDF nie korzysta z systemu sztucznej inteligencji, który identyfikuje terrorystów, ani nie próbuje przewidzieć, czy dana osoba jest terrorystą. Systemy informacyjne to jedynie narzędzia dla analityków w procesie identyfikacji celów” – stwierdziła IDF w oświadczeniu. Zaprzeczenia te nie były jednak traktowane poważnie. Tym bardziej, że Izrael właśnie zwolnił dwóch oficerów odpowiedzialnych za ataki.

Wiadomo, że Lavender został opracowana przez oddział wywiadowczy Izraelskich Sił Obronnych, Unit 8200, który jest porównywany do amerykańskiej Agencji Bezpieczeństwa Narodowego czy GCHQ w Wielkiej Brytanii.

Już wcześniej mówiło się o innym izraelskim systemie sztucznej inteligencji „Ewangelia”, który był używany do oznaczania budynków lub struktur, z których prawdopodobnie działa Hamas. Według raportu +972 Magazine również przyczynił się również do wielu ofiar wśród ludności cywilnej. Ewangelia jest znacznie szybsza od całych grup analityków. Grupa 20 oficerów może namierzyć 50-100 celów w ciągu 300 dni. Ewangelia zrobi to 50 razy szybciej.

Zastosowanie takich systemów wzbudziło protesty na świecie. Rzecznik ds. bezpieczeństwa narodowego Białego Domu John Kirby poowiedział, że Stany Zjednoczone analizują doniesienia mediów mówiące, że izraelskie wojsko wykorzystuje sztuczną inteligencję do identyfikacji celów bombardowań w Gazie.

Amerykański ekspert

Izrael mógł wcale nie być pierwszy w wykorzystaniu AI do identyfikacji i likwidacji celów. W 2020 roku ONZ ujawniła raport informujący o operującym na terenie Libii tureckim autonomicznym dronie, który zaatakował konwój wojskowy bez udziału człowieka. Decyzję miały podjąć algorytmy.

Z kolei na początku tego roku samoloty USA zaatakowały liczne cele w Iraku oraz Syrii. Dyrektorka ds. technologii w Centralnym Dowództwie Stanów Zjednoczonych Schuyler Moore ujawniła Bloombergowi, że wykorzystano sztuczną inteligencję do identyfikowania wrogich magazynów dronów, wyrzutni rakiet, czy centrów operacyjnych ugrupowań islamistycznych. Miały one zostać zniszczone. Był to efekt okrytego tajemnicą projektu Maven.

To inicjatywa Pentagonu, która swoje korzenie ma w 2017 r. Rozwijany od tego czasu program ma na celu wdrożenie technologii AI w sektorze obronnym. Choć sztuczna inteligencja nie decyduje o celach to – jak tłumaczy Moore – system pomaga identyfikować potencjalne zagrożenia. To on pozwolił namierzyć Amerykanom wyrzutnie w Jemenie, czy statki na Morzu Czerwonym, powiązane z bojówkami Huti.

Część ekspertów jest przekonanych, że wykorzystanie sztucznej inteligencji musi być precyzyjnie uregulowane. Zwolennikiem takich przepisów jest m.in. Kjell Carlsson, ekspert ds. strategii sztucznej inteligencji w Domino Data Lab. – To da gwarancję, że ludzie rozwijają i wykorzystują AI w sposób odpowiedzialny. Wciąż istnieją bowiem ryzyka związane z dokładnością i niezawodnością takich systemów, stąd nadzór ludzki w weryfikowaniu zaleceń AI jest kluczowy. Błędy wywołane przez algorytmy w innym wypadku mogłyby prowadzić do katastrofalnych konsekwencji i potencjalnej niezamierzonej eskalacji działań wojskowych. Pokazały to choćby niedawne amerykańskie symulacje III wojny światowej, w których AI okazałą się najbardziej radykalna w dążeniu do użycia broni nuklearnej.

Pokusa coraz szerszego używania AI, nie tylko do precyzyjnego namierzania celów, jest jednak bardzo silna. W grę wchodzą nie tylko wielkie systemy, ale i pojedyncze urządzenia, jak autonomiczne drony czy wozy bojowe namierzające cel i samodzielnie podejmujące decyzję o jego zniszczeniu. Trafiły już na linię frontu w Ukrainie. Mogą obniżyć koszt prowadzenia działań wojennych, w tym liczbę ofiar po wykorzystującej je stronie.