Zdjęcia z aresztowania Donalda Trumpa obiegły świat i uświadomiły skalę zagrożenia deepfake`ami

Michał Duszczyk

To zamknięte koło i nieustanny wyścig na technologie AI. A napędziło go pojawienie się ogólnie dostępnych narzędzi generatywnej sztucznej inteligencji (genAI), jak np. ChatGPT, Dall-E, Midjourney czy Bard. Odróżnienie dziś zdjęcia sfabrykowanego przez algorytmy czy tekstu napisanego przez bota staje się coraz trudniejsze. Człowiek do walki ze zjawiskiem niekontrolowanego rozpowszechniania treści generowanych przez boty musi więc angażować AI, bo sam nie jest już w stanie odróżnić prawdy od fałszu.

ChatGPT i Bard pomogą w manipulacji

Utwór muzyczny, który słychać w sieci, to może plagiat, zmontowany przez bota, a może praca egzaminacyjna studenta, która trafiła do rąk profesora na uczelni, została napisana przez inteligentny generator. Czy masz pewność, że zdjęcia publikowane w mediach społecznościowych to nie „dzieło” manipulacji AI?

W dobie wszechobecnej sztucznej inteligencji ludzie mogą czuć się zagubieni. Większość już teraz nie potrafi odróżnić tego, co jest prawdą, od tego, co jest fałszem. I dotyczy to zarówno tego, co czytamy, co słyszymy i co widzimy. Wielu ekspertów przestrzega: jeśli nie stworzymy systemu kontroli i weryfikacji, nie będziemy w stanie dojść, co jest fikcją. Tym bardziej że sztuczna inteligencja rośnie w siłę. Jak wynika z danych IDC, tylko w Europie wydatki na tę technologię przebiją w br. 34 mld dol., a do 2027 r. będą rosły średnio o 30 proc. rocznie. Carla La Croce, kierownik badań w IDC, prognozuje, że w ciągu czterech lat zwiększą się prawie trzykrotnie. Jak tłumaczy, genAI przyciąga uwagę producentów, konsumentów i biznesu, a najszybciej rozwijającym się przypadkiem jej użycia jest tworzenie obrazów (zdjęć i filmów) oraz tekstów.

Dość szybko, gdy w listopadzie ub.r. pojawił się ChatGPT, narodziły się projekty, które miały pomóc w identyfikacji treści i wykrywaniu „działalności” algorytmów. Jednym z takich narzędzi był GPTZero. Aplikacja stała się hitem, sięgnęło po nią wiele szkół i uniwersytetów. Jej skuteczność początkowo budziła wiele wątpliwości. Bazujący na sztucznej inteligencji system potrafił mylić się w spektakularny sposób – nie wykrywać prac pisemnych, które były dziełem AI, czy wskazywać te stworzone przez człowieka jako generowane przez boty. Było kilka głośnych przykładów studentów niesłusznie oskarżonych o oszustwo, czy historia, gdy GPTZero sklasyfikował tekst konstytucji USA jako materiał genAI.

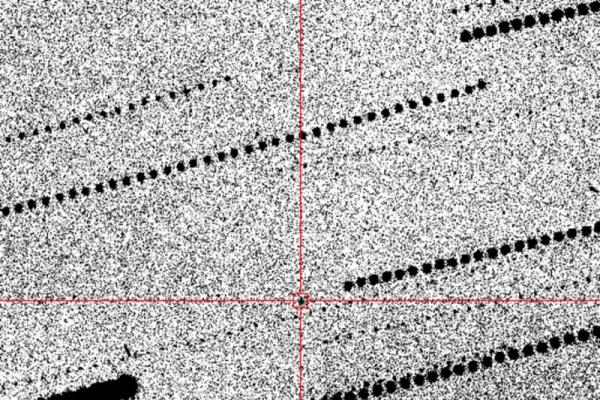

Ale narzędzia do wykrywania AI stają się coraz skuteczniejsze. Twórca GPTZero przekuł je w dobrze prosperujący biznes. Start-up ma kilkunastu pracowników i 3,5 mln dol. finansowania – w projekt zainwestowali Jack Altman (brat Sama, prezesa OpenAI) i Emad Mostaque ze Stability AI, twórcy generatora obrazów Stable Diffusion. A właśnie obrazy tworzone przez boty to potężne wyzwanie. – Za kilka lat większość zdjęć i filmów, które spotkamy w sieci, może być generowana przez AI – ostrzega Kevin Roose, felietonista „New York Timesa”.

„The Atlantic” wieszczy wręcz nadciągającą apokalipsę AI i zapowiada, że czekają nas czasy, gdy będziemy próbować odfiltrowywać tzw. generatywny szum. „Już dziś kampanie polityczne wykorzystują narzędzia AI do tworzenia spotów, a Amazon jest zalewany książkami pisanymi przez ChatGPT” – czytamy.

Bot oszukujący bota

GPTZero, ale inne detektory, jak Winston AI, którego skuteczność ma sięgać nawet 99 proc., Turnitin czy narzędzie opracowane przez OpenAI, to broń na zalew materiałów niewiadomego pochodzenia. Do walki włączyły się też Reality Defender (start-up wspierany przez Y Combinator), który wykrywa fałszywe zdjęcia i filmy, Intel (opracował narzędzie FakeCatcher), Pindrop (wykorzystuje biometrię głosu do wychwytywania spreparowanych dźwięków), czy Adobe Photoshop. Ten ostatni stworzył projekt Firefly, w ramach którego obrazy AI otrzymują specjalny znacznik. Każdy może kliknąć takie zdjęcie prawym przyciskiem myszy, by dowiedzieć się, kto i kiedy je wygenerował. GPTZero to samo chce zrobić dla tekstu. Powstało nawet konsorcjum Content Authenticity Initiative, dedykowane tworzeniu standardu autentyczności treści w mediach. Problem dostrzegli kluczowi gracze świata AI – Microsoft i Google (chcą oznaczać treści genAI znakiem wodnym). Problem w tym, że wraz ze wzrostem liczby systemów wykrywających działania bota przybywa technologii, które mają utrudniać odróżnienie tego, co jest prawdziwe, od tego, co fałszywe. Jeden z użytkowników TikToka, zaraz po powstaniu GPTZero, napisał program, który mylił detektory (zamieniał np. niektóre litery na cyrylicę). Skuteczne okazały się narzędzia do parafrazowania, jak QuillBot, program WorkNinja – chroniący przed detekcją (a właściwie tak przerabiający tekst stworzony przez bota, by wyglądał na pisany przez człowieka) – w pierwszym tygodniu od pojawienia się w sklepie z aplikacjami został pobrany ponad 350 tys. razy.